CPU、GPU、NPU和TPU的区别是什么?

人工智能开发不可或缺的机器学习使用GPU、NPU和TPU等处理芯片,但它们之间的差异一般人很难理解。 为此谷歌和云存储服务的Backblaze总结了CPU、GPU、NPU、TPU的不同。

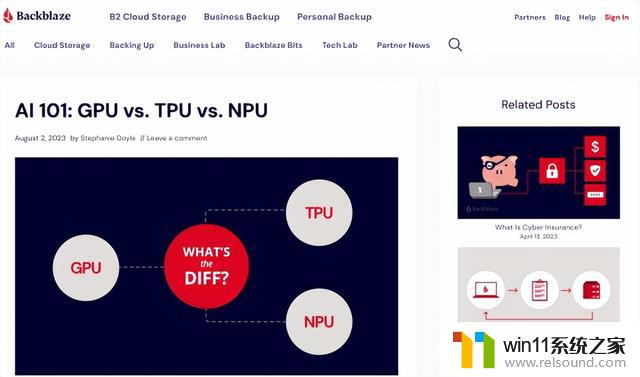

AI 101:GPU vs. TPU vs. NPU

https://m.backblaze.com/blog/ai-101-gpu-vs-tpu-vs-npu/

Cloud TPU概述| Google Cloud

https://cloud.google.com/tpu/docs/intro-to-tpu?hl=zh-cn

1、什么是CPU?

CPU是“Central Processing Unit(中央处理单元)”的缩写,用于各种目的。例如在PC上创建文档,火箭课程计算和银行交易处理。 可以在CPU上进行机器学习,但CPU具有“每次计算时访问内存”的特点,当执行机器学习所需的大量计算时,内存通信速度成为瓶颈,处理速度会变慢。

2、什么是GPU?

GPU代表“Graphics Processing Unit(图形处理单元)”,市场上广泛出现了GPU、内存、输入输出设备等配套的显卡。 GPU 配备了数千个算术逻辑单元 (ALU),擅长“并行处理大量计算”,使机器学习速度比 CPU 快得多。 但是,由于GPU是通用芯片,也可用于游戏和CG处理,因此它们的效率低于专门为机器学习设计的芯片。

3、什么是NPU?

NPU是“Neural Processing Unit(神经处理单元)”和“Neural network Processing Unit(神经网络处理单元)”的缩写,与GPU一样。它专门从事“大量计算的并行处理”的操作。 此外,NPU 是专门为机器学习设计的芯片,因此它们可以比 GPU 更有效地执行处理。 另一方面,由于NPU是专门为机器学习设计的芯片,因此它们不能像CPU和GPU那样用于各种用途。

近年来出现的许多智能手机都配备了NPU,除了在iPhone系列中配备了名为的“Neural Engine(神经引擎)”外,还有高通骁龙™(Snapdragon) 移动平台用于智能手机的SoC“”中也配备了NPU的型号。

4、什么是TPU?

TPU代表“Tensor Processing Unit(张量处理单元)”,是谷歌开发的一种NPU。 谷歌通过其云计算服务“谷歌云”为用户提供TPU处理能力,允许用户有效地执行与机器学习相关的处理,而无需自己购买搭建硬件平台。

谷歌声称其提供的TPU v4比NVIDIA专门从事机器学习相关处理的A100 GPU快1.2~1.7倍,效率高1.3~1.9倍。

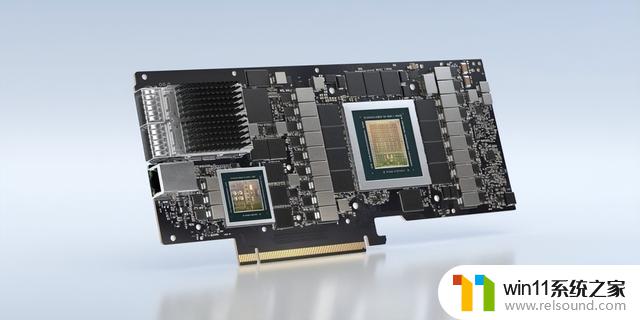

5、什么是DPU?

DPU代表“Data processing units (数据处理单元)”, 是一种可重新编程的新型高性能多核处理器。DPU与高性能网络接口相连,可增强工作并激发数据中心服务器发出的网络和存储功能。许多IT专家认为,DPU有潜力与CPU和GPU联手,成为计算世界的支柱。

NVIDIA BlueField-2X DPU