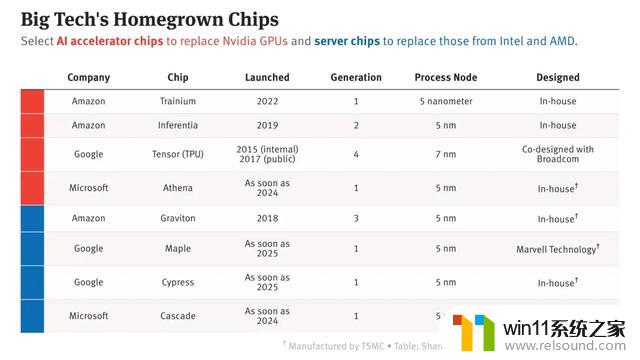

云计算巨头纷纷自研CPU,5nm成主流选项!

自研服务器芯片和AI芯片都有助于进一步降低运营数据中心的成本。

云计算大厂自研的服务器芯片通常均采用Arm架构,相比英特尔和AMD等主流服务器芯片企业提供的x86芯片具有更高性价比、更低功耗。Arm长期是智能手机芯片的主流架构,如今正成为更多新款服务器芯片的选择。

亚马逊云计算部门AWS在服务器芯片研发落地上处于领先地位,2018年就发布了第一代Graviton服务器芯片。2019年、2021年发布了第二代、第三代服务器芯片Graviton2、Graviton3。

据悉,微软的服务器芯片代号为Cascade,最早可能于明年推出。这个名字和时间表之前没有被报道过。与此同时,谷歌的芯片团队正在开发两种基于Arm的服务器芯片,最早可能在2025年用于谷歌服务器。

谷歌和微软争相追赶英伟达英伟达眼下是AI服务器芯片的关键供应商,众多企业争相购买这些芯片。估计OpenAI将需要超过30,000个英伟达的A100GPU用于ChatGPT的商业化。此前,微软称自己已经用了10,000个A100来训练ChatGPT。

英伟达最新的H100GPU在eBay上正在以超过40,000美元的价格出售,这表明对高端芯片的需求非常强劲。这些高端芯片能够帮助部署AI软件。

AI竞赛已经让高科技公司争先恐后地追赶英伟达的GPU产品。

当英伟达全力生产尽可能多的芯片以满足市场需求的时候,微软在自己公司内部开发同类AI芯片,可以用来训练大型语言模型,希望能省下从外部购买的成本。微软自己的AI芯片项目代号为Athena,该工作已经加速了。

尽管还不清楚微软会否将制造这些芯片以供给Azure云的客户使用,它计划最早明年在微软和OpenAI内部生产自己的芯片。该芯片项目的路线图已经出炉,包括了未来的几代产品。

自2019年以来,微软一直在秘密地开发芯片,微软和OpenAI的一些员工已经拿到这些芯片,以测试它们用于最新的大型语言模型GPT-4的表现如何。

据报道,微软自有芯片不会直接取代英伟达的产品,但是能够极大地降低成本,让微软能够持续推动在Office软件、Bing、GitHub和其他方面的AI化。

微软大概是科技巨头中最晚行动的一个。亚马逊、谷歌和Meta早已在内部开发AI芯片了。当然,还有许多公司仍然依赖英伟达的芯片来驱动最新的大型语言模型。

微软欲构建更安全的AI芯片供应链

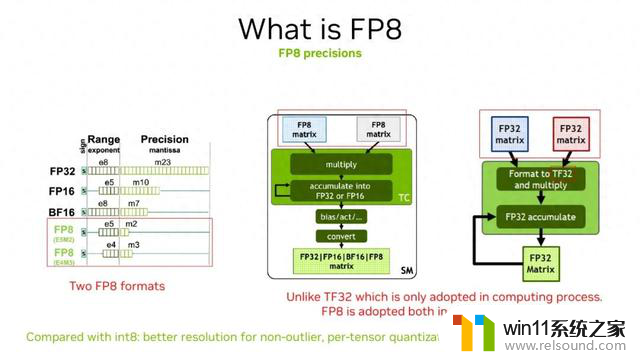

微软欲构建更安全的AI芯片供应链GPU在AI领域中扮演着重要的角色,它能够快速处理海量数据,因此可以用来加速深度神经网络的训练。此外,GPU还可以用于运行这些机器学习训练模型,以便在云端进行分类和预测,从而在耗费功率更低、占用基础设施更少的情况下能够支持远比从前更大的数据量和吞吐量。

因此在当前生成式AI爆发时期,GPU的重要性愈发凸显。对于微软而言,其本身便是市场中主要的云计算服务提供商之一,同时也是AI技术发展的重要推力。早前微软便已经向ChatGPT的开发商OpenAI注资100亿美元,并宣布将在旗下所有软件中集成ChatGPT背后的人工智能技术。

目前在微软的New Bing中已经加入了聊天机器人功能,并将生成式AI应用Copilot整合到MicrosoftTeams中,这些新功能的加入极大提升了其工作效率。其背后的商业潜力更是吸引了众多玩家参与其中,包括国内的阿里、百度、昆仑万维、商汤科技等都相继发布了自家的生成式AI。

生成式AI的爆发,对于背后的AI芯片需求大增。但目前在GPU的人工智能芯片市场中英伟达占据主导地位,其推出的A100/H100 GPU芯片主要针对AI训练以及机器学习,也是目前OpenAI支撑ChatGPT运行的最关键底层硬件。

不过微软这几年也在不断向芯片行业深入渗透中,甚至招揽了英特尔前高管Rani Borkar组建芯片部门,目前已经拥有近1000名员工。据知情人士透露,目前团队中有数百人正在从事Athena项目,为此微软已经向该项目投资了大约20亿美元。