英伟达要做AI时代台积电?其他巨头可不答应的合作计划会成真吗?

过去近30年,黄仁勋带领英伟达从一家以设计和销售GPU的半导体公司,逐渐成长为AI加速算力软硬件一体方案的芯片巨头。

在芯片大步迈入2nm时代,黄仁勋已经不满足于芯片设计者的角色,而是希望将英伟达塑造成人工智能时代基础设施。

在不久前结束的GTC开发者大会上,英伟达宣布。将会把由八块旗舰版A100/H100芯片集成的DGX超级AI计算系统通过租赁的方式开放给企业,每月租金为37000美元。

英伟达的野心已经显露无疑。不乐见于英伟达一家独大,微软、谷歌、亚马逊、ADM等纷纷入局自研AI芯片。

昔日的客户成为竞争对手,英伟达的“通用芯片”之路困难重重。

01 “淘金”不如“卖铲”

过去几个月,越来越多公司蜂拥进入AI大模型“战场”,如同1849年美国加州的淘金热。与当时淘金者们相似的是,这些公司并没有在短时间内获得大量财富。相反,许多上游公司却成了“卖铲人”,在AI大模型的繁荣中赚得盆满钵满。无论下游公司的战况多么激烈,上游公司总能是从中获益。

与ChatGPT这类AI应用不同,未来AI大模型可能并不会呈现“百花齐放”的态势。无论是巨额投入,还是考虑到生态的群聚效应,大模型都可能会朝着“赢者通吃”的方向发展,这意味着,大部分大模型都将面临被残酷淘汰的命运。然而,不管谁能够成为幸存者,“战场”背后提供“军备”的供应商总是赢家,尤其是目前无可替代的英伟达公司。

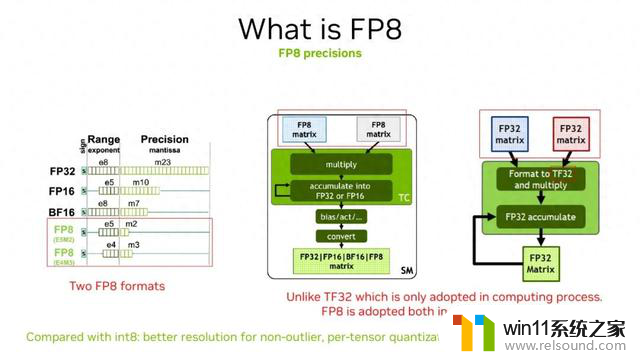

New Street Research报告显示,在全世界用于进行深度神经网络学习的GPU中,95%都是英伟达的GPU。其中英伟达A100是目前最主流的高性能GPU之一,早期ChatGPT训练和推理就是基于大量的A100 GPU,而后来更新为英伟达去年发布的H100 GPU。许多领先的AI公司,如谷歌、特斯拉和Facebook等,也都采用英伟达的GPU进行AI训练和推理。

国内众多云计算厂商和服务器厂商,如阿里、腾讯、百度、浪潮、联想等,都依赖于英伟达的高端GPU。例如,腾讯云推出的用于大模型训练的新一代HCC高性能计算集群,就采用了英伟达H800 GPU,这是英伟达为应对美国禁令而为国内市场开发的H100特供版。

随着“百模之战”带来的AI训练和推理的算力需求持续增长, “铲子”却不够卖了。据美国科技媒体The Information报道,包括亚马逊 AWS、微软Azure、谷歌GCP和甲骨文在内的主要云计算平台近期都在限制客户对云服务器的使用,一些客户称租用硬件的等待时间已经长达数月。

国内主流公有云计算平台也出现了云端GPU算力供不应求的情况,包括阿里云、腾讯云和京东云,提供英伟达A100 GPU的云产品在多个区域都已售罄或仅有少量可选。

GPU 的大规模短缺一方面可以归因于需求激增,另一方面则是 ChatGPT 的规模和发展速度超出各方意料,就连英伟达也没有准备足够的计算卡。台湾《电子时报》近期报道称,微软等客户对英伟达A100/H100芯片需求旺盛,订单已经排期至2024年,目前正在向代工厂台积电紧急追单。

美银证券半导体分析师维韦克·阿里亚对此点评道:“使用英伟达的产品并增加计算能力非常容易。目前,计算能力基本上就等同于硅谷的硬通货。”

02 英伟达的“手”伸得有多远?

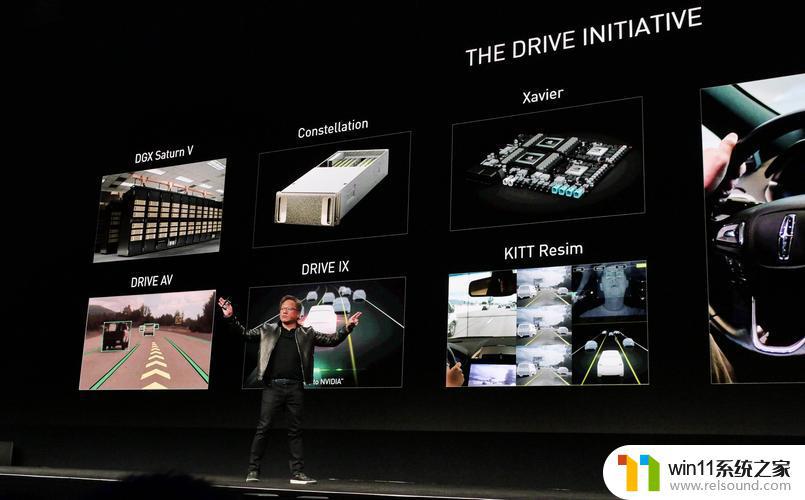

时下,面对外界庞大的AI芯片需求,英伟达已经不满足于芯片设计者的角色,而是将触角伸向基础服务设施领域。

3月21日,英伟达创始人CEO黄仁勋在GTC开发者大会上披露新了全新的人工智能及芯片技术,其中最受关注则是支撑开发ChatGPT等人工智能技术的超级计算机DGX。

为了进一步解决越来越多创业公司在大模型方面的算力需求,英伟达宣布。将会把由八块旗舰版A100/H100芯片集成的DGX超级AI计算系统,通过租赁的方式开放给企业,每月租金为37000美元,以推动加速这轮大语言模型引领的AI繁荣。

在次日的媒体采访中,黄仁勋对第一财经记者表示:“我们在欧美与云服务提供商合作,提供英伟达的DGX系统AI超级计算机的能力。在中国,我们有特别定制的Ampere和Hopper芯片。这些会通过中国云提供商,比如阿里巴巴、腾讯、百度这些企业提供落地的能力,我完全相信他们有能力去提供顶级的系统服务,对于中国初创公司一定会有机会来开发自己的大语言模型。”

据了解,黄仁勋所指的“中国可用的Ampere和Hopper芯片”就是A800和H800,这也是目前大部分中国开发者在开发大型语言模型时所使用的芯片。

同时,英伟达发布了“NVIDIA AI Foundations(英伟达AI基础大模型)”,为需要定制大型语言模型和生成AI的客户提供帮助,这些客户可以通过英伟达的DGX Cloud AI超级计算机云服务直接训练和访问大型模型产品,无需自己配置超级计算机服务。

除了计算中心,英伟达也将触角伸到了芯片代工制造领域——与台积电、ASML和新思科技等芯片代工制造企业合作。推出一款新的计算光刻应用,可大幅降低芯片代工企业在光刻工艺上的芯片消耗时间和能力,为生产2nm芯片和未来更先进的芯片做好技术储备。

以台积电为例,使用500台装有H100芯片的DGX即可替代需要4万个用驱动计算光刻的CPU服务器,可以将工厂的性能从35兆瓦直接降至5兆瓦。目前,英伟达正在与ASML、Synopsys和台积电等企业合作,预计台积电将于6月开始准备生产这种技术。

英伟达的野心已经显露无疑,当然,其他科技巨头也不会坐以待毙。

03 危险的“通用芯片”之梦

“大约在十年前我们就发现,AI这种制作方式可以改变一切。我们调整了公司方方面面的发展规划,我们生产的每一个芯片都具备人工智能技术。”

过去三十年间,英伟达制造的芯片几乎主导了整个游戏和计算机图像产业,并且极有可能在未来成为AI领域的核“芯"。而如同上一代PC霸主英特尔一样,在掌控高端GPU近九成份额后,黄仁勋和他所领导的英伟达,也开始招致外界的抵抗。

美银证券半导体分析师阿里亚认为:“对英伟达来说,最大的问题是如何保持领先地位,他们的客户也可能成为他们的竞争对手。”

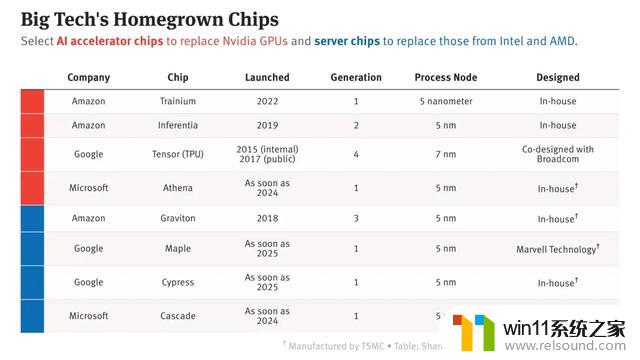

4月19日,The Information 爆料,ChatGPT背后的大股东微软正在研发自己的芯片“雅典娜”。此次微软公司自研芯片主要应用于ChatGPT背后的生成式AI 技术,用途为大语言模型训练和 AI 推理。

回顾ChatGPT长达五年的产品研发落地历程,为了训练ChatGPT,微软可谓下了血本。目前,微软使用的AI芯片是英伟达芯片。根据相关资料,ChatGPT消耗的总算力约为3640PF-days,假如每秒计算一千万亿次,需要计算3640天。微软将3万多个英伟达A100芯片连起来为OpenAI打造超级算力,已耗费数亿美元。按照这种趋势,日后花费只会更甚,还经常会被芯片供应商掣肘。

芯片行业研究公司SemiAnalysis首席分析师迪伦·帕特尔表示,由于ChatGPT运行在价格昂贵的计算基础设施之上,OpenAI每天为运行ChatGPT投入的成本可能高达70万美元。

因此,微软自研AI芯片,不仅为了减少对英伟达的依赖,节省其在AI业务上的成本,也是应对同行压力的必由之举。毕竟,随着生成式AI大爆发,谷歌、亚马逊等科技巨头都已推出自研芯芯片,试图赶上英伟达在AI芯片市场上的统治地位。

4月24日早间消息称,谷歌将其专门负责AI芯片开发的团队转移至谷歌云部门。谷歌之所以这样调整,主要是因为想增强云计算团队的竞争力,以追赶强敌亚马逊云和微软云。

早在二月,The Information报道,谷歌在数据中心芯片研发方面已取得进展,有望于2025 年开始使用新的芯片。谷歌伺服器设计团队已努力至少两年时间,其两款晶片技术建立在Arm Holdings 的技术之上,台积电可能会在2024 年下半年开始量产这两款芯片。

四月初,谷歌研究人员在一篇论文中公布了用于训练AI模型的超级计算机的技术细节,包括如何将4000多个自研的第四代TPU芯片连接成一台超级计算机,通过协同来训练模型。谷歌宣称,该系统比基于英伟达GPU的超算系统速度快了1.7倍,能效提升1.9倍。

从长远来看,未来大模型的研发和部署是必然趋势,每个大模型训练和部署的背后,都需要成千上万个GPU芯片支持。随着谷歌、微软、亚马逊等科技巨头开始设计自己的定制芯片,竞争也在加剧,并有望像GPU打败CPU一样,改写黄仁勋在AI芯片领域的绝对主导地位。

算力是运行模型的基础,场景是运用模型的环境。To C的大模型是大厂的主战场,但它们在To B上却无法做到赢家通吃。要将“ChatGPT”送入千行百业,在通用大模型之外,低算力消耗的专用“小”模型也将诞生更多机会。

目前,AI场景并未固定,而是不断扩展和演进。未来,随着新的应用场景涌现,也许会催生新的细分需求,从而影响芯片产品的形态。因此,对于国内创业公司而言,通过触达更多的实际使用场景来夯实自己在芯片领域的算力优势,打造其他竞争对手难以逾越的技术障碍,将是新的成长机会。

本文源自亿欧网