iPhone上本地每秒生成12个tokens,微软发布phi-3-mini模型,加速AI模型部署速度

更新时间:2024-04-23 13:45:12作者:relsound

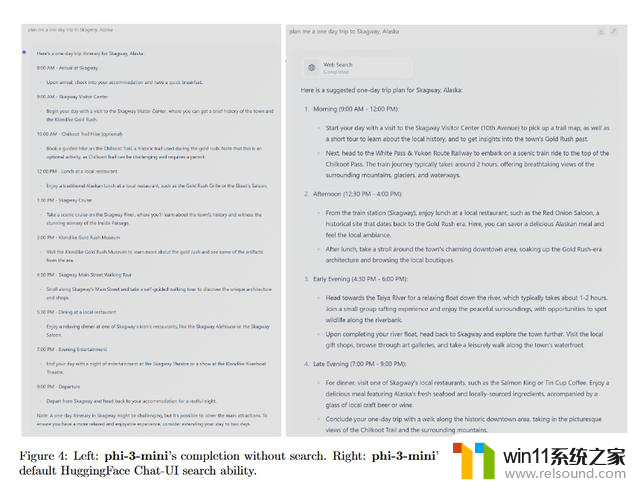

4 月 23 日消息,微软研究院近日发布技术报告。公布了 Phi-3 系列 AI 模型,共有 mini(38 亿参数)、small(70 亿参数)和 medium(140 亿参数)三个版本。

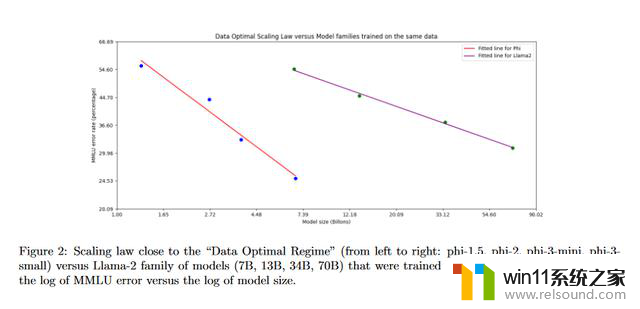

微软表示拥有 38 亿参数的 phi-3-mini 通过 3.3 万亿个 tokens 上训练,其基准跑分性能超出 Mixtral 8x7B 和 GPT-3.5。

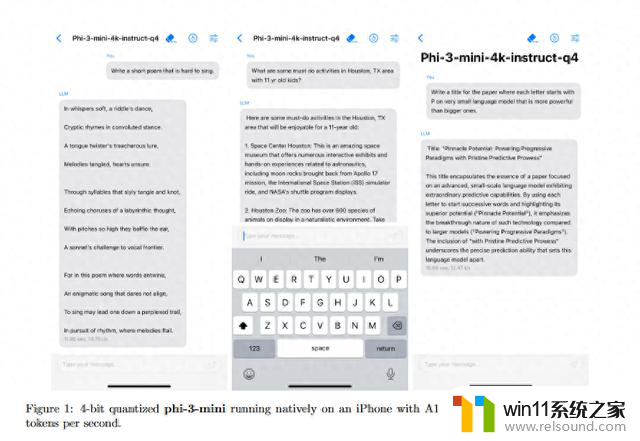

微软表示 phi-3-mini 模型可以部署在手机等设备上,在 27 亿参数的 Phi-2 模型上,进一步整合了严格过滤的网络数据和合成数据。

微软也坦言 phi-3-mini 模型虽然通过优质数据在语言理解和推理能力上媲美更大参数的 AI 模型,但在 TriviaQA 等某些任务上依然受到模型规模的限制。

微软还表示 phi-3-small 和 phi-3-medium 两个模型在 MMLU 上的得分分别为 75.3 和 78.2。

附上参考