英伟达深夜上新AI芯片H200,内存容量翻倍

编辑 |苏建勋

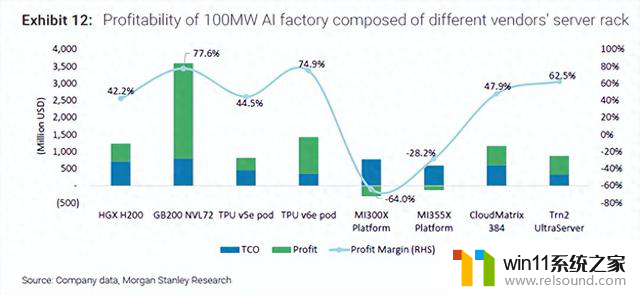

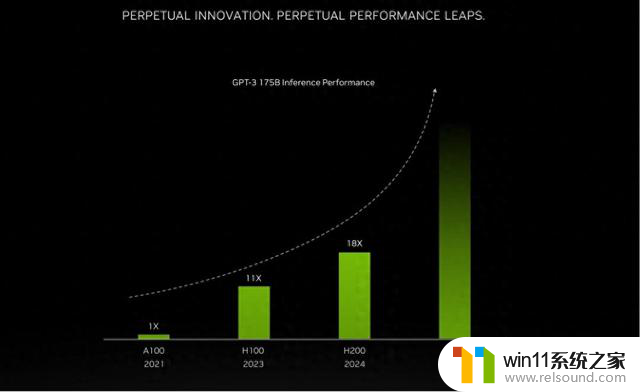

北京时间11月13日傍晚,英伟达又推出了 NVIDIA HGX H200,一种比H100性能更强的下一代产品。据英伟达表示,该产品将于2024年二季度上市。此外,英伟达还透露,将在2024年发布基于新一代架构Blackwell的B100 GPU,且将H100的产量增加两倍至200多万块。

人工智能市场的火热,正迫使英伟达加速上新速度。H100芯片发布至今仅8个月,英伟达又发新芯。

英伟达产品规划,来自官网

H200是H100的升级产品,仍然采用 NVIDIA Hopper 超级芯片架构,主要面向超大规模的大模型训练和推理工作场景。

作为H100的升级版本,H200将会具有H100的所有功能,如用来加速基于Transformer架构搭建的深度学习模型的Transformer Engine功能。

它最大的改变在于内存。存储大小是算力芯片的性能指标,H200是首款具有HBM3e的GPU,这是三星所能提供的最强内存,能很好地为生成式AI和大语言模型提供数据存储空间。与上一代H100相比,NVIDIA H200 能以每秒 4.8 TB 的速度提供 141GB 内存,容量几乎翻倍,带宽增加 2.4 倍。

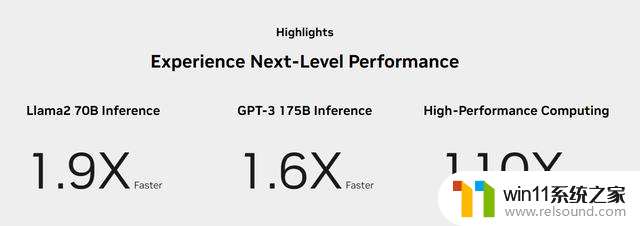

英伟达并未专门介绍H200与之前产品原始计算吞吐量的区别,不过。在采用了HBM3e的内存后,以基于Meta的Llama 2大模型的测试为例,H200的输出速度大约可以达到H100的1.9倍,H200对GPT-3.5的输出速度则是H100的1.6倍。

H200产品性能对比,来自官网

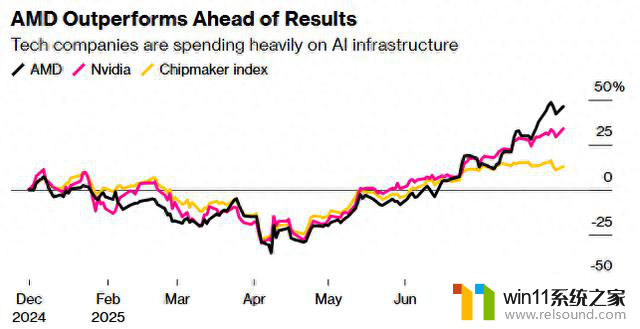

此前,AMD才发布了以大内存为主要特点的新品MI300X GPU,希望帮助大语言模型运算推理,英伟达H200发布后,会加剧在大模型推理市场的竞争。

除了以内存为主要升级重点的H200加速器,英伟达还发布了HGX H200 平台。

HGX H200会以4 路和 8 路的配置提供,它可以用在本地、云、混合云和边缘等不同类型的数据中心上。该产品将部署于Amazon Web Services、Google Cloud、Microsoft Azure 和 Oracle Cloud Infrastructure等平台,预计2024年第二季度推出。

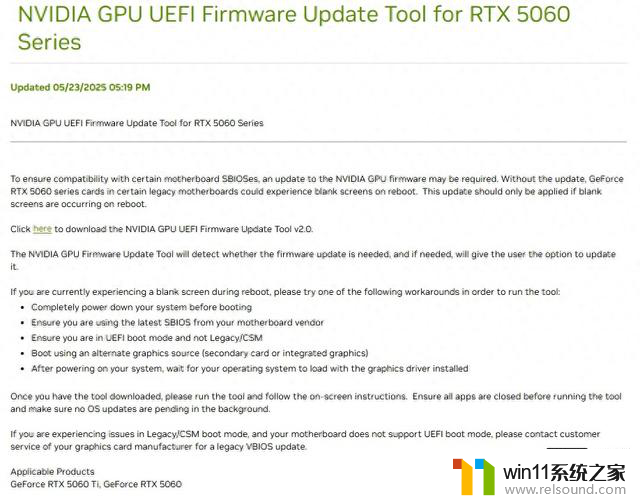

英伟达表示,H200在使用上可以和H100兼容,这能保证基于英伟达芯片进行模型训练的用户,在不更改服务器、软件的情况下就可以无缝衔接到新产品。

令人遗憾的是,英伟达的H200作为一款比H100更强的新品,无法在中国市场销售。英伟达官方邮件回应36氪,H200需要获得相关出口许可证才能在中国市场销售。

不过。近日,有消息称,英伟达已开发出针对中国市场的最新改良版系列芯片——HGX H20、L20 PCle和L2 PCle,主要基于H100改良而来,最快将于本月16号之后公布。